Date

04.12.2023

Comment une technologie basée sur GPT-4 peut être utilisée concrètement dans des applications métiers.

Le monde de l’informatique est en perpétuel mouvement, comme un fleuve turbulent. Les possibilités de l’intelligence artificielle (IA) et des Large Language Models (LLM) y ont fait naître une vague impressionnante d’innovations et de progrès. Mais si vous ne vous y jetez pas résolument, vous resterez dans les eaux calmes des anciennes technologies.

En kayak en eaux vives, il y a une règle de base: si vous voulez descendre la rivière sans encombre, vous devez vous lancer consciemment et activement dans le courant. Inutile de s’attarder dans les contre-courants, vous n’avancerez pas. Il faut au contraire plonger courageusement dans le courant, car c’est de toute façon en pratiquant que l’on acquiert de l’expérience.

Bedag évolue dans ces eaux tourmentées depuis 2017 déjà. À l’époque, nous avons donné nos premiers coups de pagaie dans le domaine de l’apprentissage machine pour et avec nos clients. Débarrassés de nos peurs, c’est donc avec curiosité et confiance que nous avons plongé cette année encore dans le courant et que nous avons bâti et testé les cas d’utilisation ci-dessous à l’aide de Large Language Models (LLM):

Un agent conversationnel génératif pour la chancellerie d’État

Pour le secrétariat à l’administration numérique de la chancellerie d’État du canton de Berne, nous avons adapté GPT-4 afin d’en faire un chatbot spécialisé dans la loi sur l’administration numérique (LAN). Pour ce faire, nous avons exploré les limites du bot et lui avons apporté la touche finale grâce à des données toujours mieux traitées. Le bot de la LAN connaît désormais les textes de loi et les ordonnances sur le bout des doigts, parle couramment français et allemand et est toujours à jour grâce à des données actualisées, sans pour autant perdre l’historique. En bref: grâce à sa solide expertise, associée à une juste dose d’humour et de culture générale, le bot de la LAN sait se montrer convaincant.

Une programmation plus rapide et plus fiable grâce à CodeAssist@bedag

En interne aussi, notre objectif est d’aider nos collaboratrices et collaborateurs férus de technologie grâce à l’IA. Écrire rapidement du code, des scripts et des configurations impeccables? Aucun problème. Nous avons installé CodeAssist@bedag sous forme de Proof of Concept sur deux puissants GPU (processeurs graphiques). Bien sûr, il faut toujours maîtriser Kubernetes, les pipelines de déploiement, la création de prompt templates et les fenêtres contextuelles, mais ces compétences font partie de nos fondamentaux, comme le gilet de sauvetage en kayak. Nous sommes encore en train de tester comment utiliser CodeAssist@bedag de manière optimale dans la pratique, mais il est d’ores et déjà clair que nous ne travaillerons bientôt plus sans CodeAssistant, qu’il fonctionne sur un cloud privé (localement) ou sur le cloud public. Une glisse un peu plus rapide, qui n’en voudrait pas?

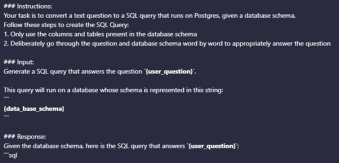

«Ask Data» – les applications métiers répondent aux questions

Et nos applications métiers alors? Là encore, les LLM peuvent être utiles: Dans le cadre d’un Innosprint, nous cherchons actuellement à remplacer la syntaxe SQL (Structured Query Language), fastidieuse, par le langage naturel des experts. Grâce à «Ask Data», nous espérons créer une fonctionnalité permettant aux experts d’obtenir des réponses immédiates fondées sur les données. Nous avons déjà pu générer des SQL simples et à la syntaxe correcte pour le modèle de banque de données de SUSA (circulation routière). Mais avant que «Ask Data» parle couramment avec la banque de données SUSA, NESKO ou CAPI, il faudra encore quelques coups de pagaie. Nous sommes ravis d’explorer la prochaine boucle du fleuve grâce à cette fonctionnalité expérimentale.

Vous aussi, vous voulez plonger dans les eaux tumultueuses de l’intelligence artificielle et des Large Language Models (LLM)? Les spécialistes de Bedag possèdent une solide expérience dans l’apprentissage machine. Combinée à la connaissance de votre secteur, elle fait de nous un partenaire de confiance. Vous voulez vous aussi utiliser concrètement les LLM? Contactez notre gestionnaire de compte par e-mail à l’adresse vlynschwbbdgch ou par téléphone au 079 434 96 20.