Datum

04.12.2023

Wie GPT-4-basierte Technologie konkret bei Fachapplikationen eingesetzt werden kann.

Die IT-Welt ist in Bewegung wie ein wilder Fluss. In diesem tosenden Gewässer haben die Möglichkeiten der künstlichen Intelligenz (KI) und derLarge Language Models (LLMs) eine beeindruckende Welle von Innovationen und Fortschritten hervorgebracht. Wer sich jedoch nicht aktiv in diesen Fluss wagt, bleibt im ruhigen Kehrwasser der alten Technologien zurück.

Beim Wildwasser-Kajakfahren gibt es eine grundlegende Regel: Wer den Fluss erfolgreich befahren will, muss sich bewusst und aktiv in die Hauptströmung wagen. Es bringt nichts, im ruhigen Kehrwasser zu verharren und nicht weiterzukommen. Stattdessen soll man mutig in den wilden Flow eintauchen. Die meisten Erfahrungen sammelt man ohnehin «on the ride».

Bei der Bedag bewegen wir uns schon seit 2017 in diesem bewegten Wasser. Damals haben wir für und mit unseren Kundinnen und Kunden unsere ersten Paddelschläge im Bereich des maschinellen Lernens unternommen. Wir sind daher nicht mehr ängstlich, sondern sind auch in diesem Jahr weiter mit Neugier und Zuversicht in die Hauptströmung eingetaucht. Dabei haben wir folgende Use Cases mit Large Language Models (LLMs) hands-on aufgebaut und getestet:

Generativer Chatbot für die Staatskanzlei

Für die Geschäftsstelle Digitale Verwaltung der Staatskanzlei des Kantons Bern haben wir GPT-4 als fachdomänenspezifischen Bot für das Gesetz über die digitale Verwaltung (DVG) adaptiert. Dabei haben wir die Grenzen des Bots ausgelotet und ihm mit immer besserer Datenaufbereitung den letzten Schliff verpasst. Nun kennt der DVG-Bot die Gesetzestexte und Verordnungen rund ums DVG auswendig, spricht fliessend Deutsch und Französisch und bleibt dank aktualisierbaren Dokumenten immer auf dem neuesten Stand – ohne dabei die Historie zu vergessen. Kurzum: Der DVG-Bot überzeugt durch sein ausgeprägtes Fachwissen, kombiniert mit der richtigen Portion Humor und Allgemeinwissen.

Schneller und zuverlässiger programmieren mit CodeAssist@bedag

Auch intern wollen wir unsere technikaffinen Mitarbeitenden mit KI unterstützen. Rasch fehlerfreie Codes, Scripts und Konfigurationen schreiben? Klar geht das! Auf zwei leistungsstarken GPUs (Grafikprozessoren) haben wir CodeAssist@bedag als Proof of Concept gebaut. Okay, mit Kubernetes, Deployment-Pipelines, Prompt-Templating und Context-Windows muss man sich natürlich immer noch auskennen, aber diese Skills gehören ja zu uns wie die Schwimmweste zum Kajak. Wie der CodeAssist@bedag in der Praxis optimal eingesetzt werden kann, testen wir noch. Aber klar ist schon heute: In Zukunft werden wir – egal ob in der Private Cloud (on premises) oder in der Public Cloud – nicht mehr ohne CodeAssistant arbeiten. Und gegen eine höhere Fliessgeschwindigkeit hat ja sowieso niemand etwas, oder?

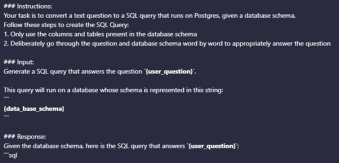

«Ask Data» – Fachapplikationen geben Antworten

Und unsere Fachapplikationen? Auch da können LLMs hilfreich sein: Aktuell arbeiten wir in einem Innosprint daran, die lästige SQL-Syntax (Structured Query Language) durch die natürliche Sprache der Fachexperten zu ersetzen. Mit «Ask Data» streben wir ein Feature an, mit dem Fachexperten ad hoc datenbasierte Antworten erhalten. Für das Datenbankmodell von SUSA (Strassenverkehr) konnten wir bereits einfache und syntaktisch korrekte SQLs erzeugen. Bis «Ask Data» aber fliessend mit der SUSA-, NESKO- oder CAPI-Datenbank «spricht», braucht es noch etwas Kajak-Training. Wir freuen uns, mit diesem «Experimental Feature» die nächste Flussbiegung zu erkunden.

Wollen auch Sie in die Wildwasser der künstlichen Intelligenz und Large Language Models (LLMs) eintauchen? Die Spezialistinnen und Spezialisten der Bedag haben fundierte Erfahrung im Bereich des maschinellen Lernens. Kombiniert mit unserer Kenntnis Ihres Geschäfts macht uns dies zu einem vertrauenswürdigen Partner. Möchten auch Sie konkret LLMs einsetzen? Bitte kontaktieren Sie unsere Account Managerin per E-Mail unter vlynschwbbdgch oder telefonisch unter 079 434 96 20.