Date

29.03.2023

Tout comme les marchandises traversent aujourd’hui les mers du monde entier dans des conteneurs et non plus directement dans la coque d’un navire, les applications logicielles sont de moins en moins installées directement dans le système d’exploitation, mais gérées au moyen de conteneurs. Cela permet de réduire la complexité, d’augmenter l’efficacité et de faciliter la gestion des incidents et des problèmes.

La conteneurisation consiste à emballer le code logiciel dans un paquet qui contient tous les composants nécessaires et qui sont isolés. De cette manière, le logiciel dans son conteneur peut être déplacé dans différents environnements et être exécuté de manière cohérente sur différentes infrastructures, en grande partie indépendamment de l’environnement ou du système d’exploitation de l’infrastructure.

La volonté de pouvoir exploiter des logiciels indépendamment de l’infrastructure a une longue histoire dans l’informatique. Au début, la conception était majoritairement physique et chaque système était fermé sur lui-même ; il constituait une entité entre le matériel, le système d’exploitation et les applications proprement dites. À l’exception de la technologie mainframe prête une vingtaine d’années plus tôt, le début de ce millénaire a vu l’avènement de la virtualisation qui a permis d’exploiter plusieurs systèmes d’exploitation (Windows, Linux) sur une même plateforme matérielle. Les environnements d’exécution virtuels ont également été de plus en plus fréquents, leur but étant d’exploiter plusieurs applications de manière isolée sur un système. Un format courant à cet effet était par exemple Java Archive (JAR), qui permettait de livrer des paquets entiers sous forme de mini-conteneurs et de les déployer (distribuer) sans que des directives d’installation soient nécessaires. Certes, il fallait toujours en principe une couche de système d’exploitation minimale, sur laquelle se greffaient ensuite les différents environnements avec leurs applications et composants middleware correspondants.

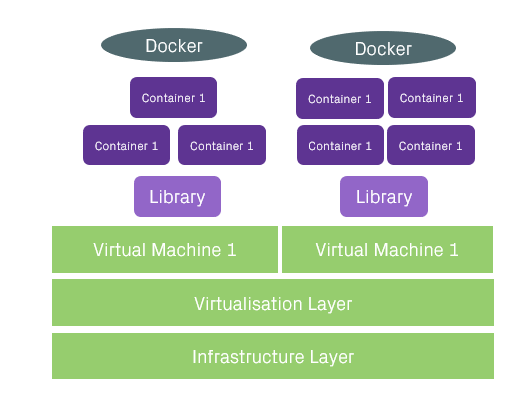

La conteneurisation a véritablement pris son envol avec le lancement de Docker en 2013, ce qui permet d’éliminer les codes du système d’exploitation superflus pour une application ou un fragment d’application (conteneur). Le poids d’un système d’exploitation est ainsi réduit au maximum. C’est la fin des serveurs géants dans lesquels chaque code est stocké individuellement et l’avènement des microservices dans lesquels la part du système d’exploitation est plus petite, au profit du code effectif.

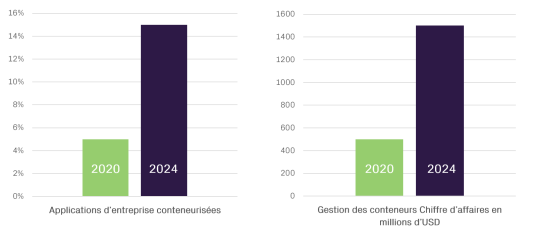

Tendances du marché de la conteneurisation selon Gartner

L’utilisation de conteneurs est en très forte croissance dans le monde entier et s’est imposée dans de nombreuses entreprises. Le développement agile de logiciels, avec des cycles de développement de plus en plus rapides dans des environnements hétérogènes, nécessite une abstraction programmable de l’environnement d’exécution dans le système d’exploitation. Kubernetes (K8s) s’est imposé pour gérer et orchestrer le grand nombre de conteneurs.. Revenue Growth for Container Management Software | Gartner

Quels sont les avantages d’un conteneur ?

La conteneurisation implique la fusion des travaux du centre de calcul et du développement de logiciels, ce qui conduit à l’approche DevOps. La conteneurisation est le prolongement moderne de la plateforme as a service avec une interface standardisée sur celle-ci. Les applications fonctionnent ainsi indépendamment de l’environnement cible, ce qui simplifie considérablement les tests unitaires et les déploiements, notamment. Un conteneur se comporte en principe de la même manière, quel que soit l’environnement. Du point de vue des ressources, l’overhead est minimisé, ce qui permet une meilleure utilisation du matériel utilisé. Dans un environnement virtualisé, la couche du système d’exploitation a besoin d’environ un à deux gigaoctets de mémoire, alors que dans les conteneurs légers, elle n’a besoin que de 20 à 50 mégaoctets. L’utilisation supplémentaire d’une solution d’orchestration (par exemple Kubernetes) offre ainsi d’autres options comme le self-healing, l’autoscaling et la modélisation des services. Il est ainsi possible de connaître l’état de « santé » du conteneur de manière automatisée. Si celui-ci n’est pas en ordre, le conteneur est automatiquement soit redémarré, soit même démarré depuis un autre endroit, de sorte que l’application soit à nouveau disponible.

Un conteneur contient non seulement le logiciel proprement dit, mais aussi le middleware nécessaire à son exécution et, bien entendu, les composants correspondants du système d’exploitation. On peut se servir de différentes bibliothèques et y ajouter son propre code. Le tout est scellé dans un conteneur, et ce conteneur peut ensuite être démarré depuis un serveur Docker ou Kubernetes.

Il en résulte des microservices individuels qui fonctionnent en principe indépendamment les uns des autres et qui sont commandés par des interfaces – pour être mis à disposition une ou plusieurs fois. Un microservice peut être réparti sur plusieurs conteneurs, mais il se peut aussi qu’un microservice soit également un conteneur. Le microservice est l’élément d’application que nous voulons réellement utiliser en tant qu’utilisateur, il s’agit donc d’un élément de l’architecture logicielle. Le conteneur, quant à lui, est le « véhicule d’exploitation » et constitue un élément de l’architecture d’exploitation.

Meilleure collaboration entre le développement et l’exploitation

Les méthodes de travail peuvent être hautement automatisées grâce à l’utilisation de conteneurs, et la collaboration entre les développeurs et l’exploitation évolue vers une collaboration plus étroite (DevOps). Auparavant, des manuels d’utilisation précisaient les étapes de travail pour intégrer un logiciel dans l’entreprise. Cette rupture de média entraînait une perte de savoir-faire entre le développeur qui avait écrit le manuel et l’employé du centre de données qui avait installé le logiciel.

Dans les déploiements basés sur des conteneurs, ces « manuels » sont directement déposés sous forme de code logiciel lisible par une machine, ce qui rend le paquet de logiciels indépendant de l’environnement cible. Cela simplifie le processus d’intégration, réduit notamment les activités manuelles et donc sujettes aux erreurs, et améliore ainsi la qualité. Le développeur de logiciels peut ainsi valider son conteneur pour que ce dernier soit déployé et l’agent d’exploitation le déploie dès que le Change Management l’y autorise. Il est important que le processus de déploiement reste intégré à la gestion des changements afin de garantir un fonctionnement stable même avec ce haut niveau d’automatisation. Ainsi, tout le monde dans l’entreprise sait ce qui a été modifié, quand et où, afin qu’en cas d’incident, les informations correspondantes soient également disponibles. Les applications basées sur des conteneurs bénéficient de la même protection réseau que le reste de notre infrastructure. Cette protection est adaptée en fonction de l’état actuel des menaces, qui est surveillé en permanence par notre SOC.

Bedag exploite actuellement pour ses clients près de 500 services basés sur des conteneurs, pour des applications comme par exemple les services GeoDB, les services BE-Login, la plateforme pour les votations BEWAS du canton de Berne, Swiss ePolice ou le serveur statistique de l’ASA. Notre longue expérience garantit donc à nos clients une disponibilité et une sécurité des données maximales. Nous nous occupons de votre architecture cloud afin que vous puissiez vous concentrer sur votre cœur de métier. Nous ouvrons une voie facile vers un environnement informatique efficace géré avec Managed Kubernetes afin que vous puissiez déployer vos applications de manière agile et selon vos besoins individuels.